AI悪用対策の現状と未来

AIの初心者

先生、「悪用へのセキュリティ対策」って、具体的にどんなことをするんですか?フェイクニュースとか、偽の画像とか作られてしまったら、もうどうにもならないんじゃないですか?

AI専門家

そうだね、確かに悪用を防ぐのは難しい。だから、作られた後を見破る技術が重要になってくるんだ。例えば、マイクロソフトや他の会社が、偽物を見破るための道具を開発しているんだよ。

AIの初心者

へえー、そんな道具があるんですね!でも、悪いやつらもどんどん新しい方法を考えるんじゃないですか?

AI専門家

その通り!だから、いたちごっこなんだ。だから、常に新しい情報を知って、対策をアップデートしていく必要があるんだよ。

悪用へのセキュリティ対策とは。

人工知能を使った技術は、偽の情報を作ることに悪用されることがあります。例えば、自然な文章を作る技術を使えば、偽のニュースを作ることができ、画像を作る技術を使えば、本物そっくりの偽動画を作ることができます。こうした技術は、研究論文などで公開されていることが多く、悪用されるのを事前に防ぐのは難しいです。そのため、悪用された後への対策が重要になります。マイクロソフト社の「マイクロソフトビデオオーセンティケーター」やサマライズボット社の「フェイクニュースディテクション」のように、偽物を見破る技術が研究されていて、こうした技術を使うことが有効です。人工知能の悪用とその対策は、いたちごっこのようになっていて、常に最新の情報を集めることが大切です。

人工知能の悪用事例

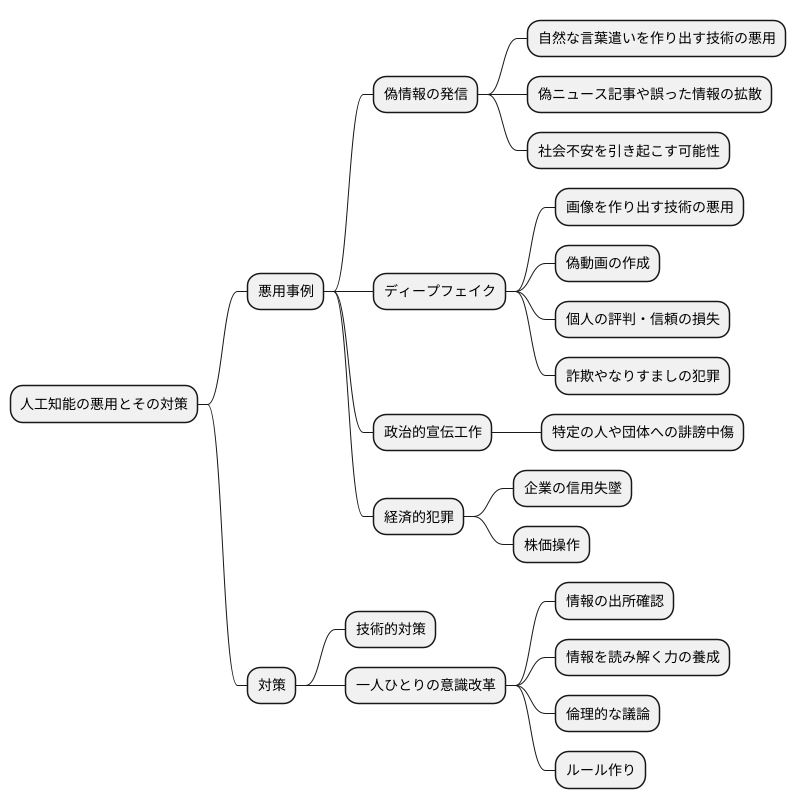

人工知能は、私たちの暮らしを便利で豊かにする大きな可能性を秘めていますが、それと同時に、使い方を誤れば社会に悪影響を及ぼす危険性も持っています。この技術の進歩は驚くほど速く、今後さらに巧妙な悪用の手口が現れることも心配されます。だからこそ、私たちは人工知能が悪用される危険性についてしっかりと理解し、適切な対策を考えていく必要があります。

人工知能の悪用事例として、まず挙げられるのは、自然な言葉遣いを作り出す技術を悪用した偽の情報の発信です。まるで人間が書いたかのように自然な文章で、偽のニュース記事や誤った情報を大量に作り出し、インターネット上に拡散することが可能です。このような偽の情報は人々の判断を狂わせ、社会不安を引き起こす可能性があります。

また、画像を作り出す技術を悪用した「ディープフェイク」も深刻な問題です。これは、実在する人の顔を別の人の顔に合成したり、実際には言っていないことを言っているかのように動画を加工したりする技術です。この技術を使えば、本物と見分けがつかないような偽の動画を作成できます。ディープフェイクは、個人の評判を傷つけたり、信頼を損なったりするだけでなく、詐欺やなりすましなどの犯罪にも利用される恐れがあります。

これらの技術が悪意のある人物によって利用された場合、政治的な宣伝工作に利用されたり、特定の人や団体に対する誹謗中傷を拡散するために使われたりする可能性があります。また、企業の信用を失墜させたり、株価を操作したりといった経済的な犯罪にも悪用されるかもしれません。

人工知能の悪用を防ぐためには、技術的な対策だけでなく、私たち一人ひとりの意識改革も重要です。情報の出所を確認する習慣を身につけたり、不確かな情報に惑わされないように注意したりするなど、情報を読み解く力を養うことが大切です。また、人工知能に関する倫理的な議論を進め、悪用を防ぐためのルール作りも必要です。人工知能の恩恵を正しく享受するためにも、私たちは技術の進歩と同時に、その利用方法について真剣に考えていく必要があるでしょう。

悪用を防ぐ難しさ

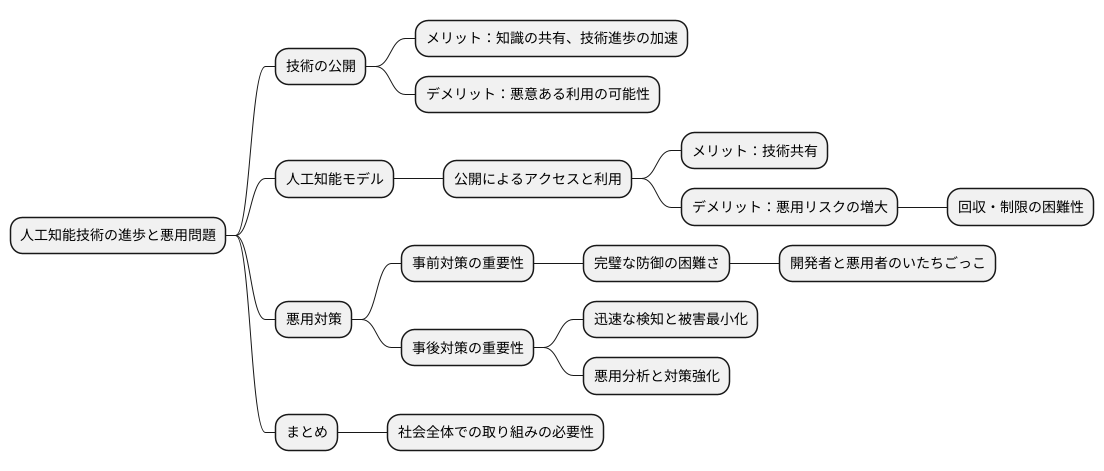

人工知能の技術は日進月歩で進歩しており、その研究成果は論文などの形で広く公開されています。これは、世界中の人々が知識を共有し、技術の進歩を加速させる上で非常に大切なことです。しかし、同時に大きな問題も抱えています。誰でも利用できるということは、悪意を持った人々がその技術を悪用する可能性も秘めているということです。

人工知能モデルも例外ではありません。高度な技術を駆使して開発されたモデルが公開されると、誰でもアクセスし、利用することが可能になります。これは技術の共有という観点では素晴らしいことですが、同時に悪用のリスクを高めてしまうのです。公開されたモデルを回収したり、特定の人物だけに利用を制限することは、現実的にほぼ不可能です。一度インターネット上に公開された情報は、完全に消去することは極めて難しいからです。

悪用を防ぐための対策を事前に講じることはもちろん重要ですが、残念ながら完璧に防ぐことは非常に困難です。なぜなら、悪意を持った人々は常に新しい悪用の手段を模索し続けているからです。まるでいたちごっこの様に、開発者と悪用者の間での終わりなき戦いが繰り広げられています。

そのため、人工知能モデルの悪用問題に対しては、事前の対策だけでなく、悪用された後の対応も非常に重要になってきます。悪用された場合に迅速に検知し、被害を最小限に抑えるための体制を構築しておく必要があります。また、悪用されたモデルを分析し、その手口を理解することで、将来の悪用を防ぐための対策を強化していくことも大切です。人工知能技術の発展と安全確保の両立は、複雑で難しい課題ですが、社会全体で取り組んでいくべき重要な課題と言えるでしょう。

悪用への対策技術

人工知能は便利な道具ですが、使い方を誤ると悪い目的にも使われてしまうことがあります。それを防ぐために、様々な対策技術が作られています。

例えば、動画が本物か偽物かを見分ける技術があります。マイクロソフト社が作った「マイクロソフト 映像認証器」という技術では、動画に人工知能で手を加えた痕跡がないか細かく調べ、偽物かどうかを判断します。人の目ではわからないようなわずかな変化も見つけることができます。

また、インターネット上には間違った情報や嘘のニュース記事が出回ることがあります。それを自動で見つける技術も開発されています。「要約ロボット 偽ニュース発見」という技術は、ニュース記事の内容を分析し、他の記事と比べて矛盾する点や不自然な点がないかを調べます。

これらの技術は、悪用された情報が広く伝わってしまうのを防ぐのに役立ちます。偽物の動画やニュース記事を見つけた場合は、すぐに削除したり、警告を出したりすることで、人々が騙されるのを防ぎます。

さらに、情報の信頼性を確かめるための技術も開発されています。情報の出典や発信元、他の情報との整合性などを総合的に判断することで、情報の信頼度を点数で表すシステムも作られています。これにより、人々はどの情報が信頼できるかを判断しやすくなります。

悪用を防ぐ技術は日々進化していますが、悪用する側も新しい方法を考え出すため、いたちごっこになっています。そのため、常に新しい対策技術を研究開発していく必要があります。より安全に人工知能を使うためには、技術の進歩だけでなく、人々の倫理観や情報を見極める力も重要です。

| 対策技術 | 目的 | 仕組み |

|---|---|---|

| 動画真偽判別技術 (例: マイクロソフト 映像認証器) |

偽動画の拡散防止 | 動画にAIによる加工の痕跡がないか細かく調べる |

| 偽ニュース検出技術 (例: 要約ロボット 偽ニュース発見) |

偽ニュースの拡散防止 | ニュース記事の内容を分析し、他の記事と比べて矛盾点や不自然な点がないか調べる |

| 情報信頼性評価技術 | 情報の信頼性判断支援 | 情報の出典や発信元、他の情報との整合性などを総合的に判断し、信頼度を点数で表す |

最新情報の重要性

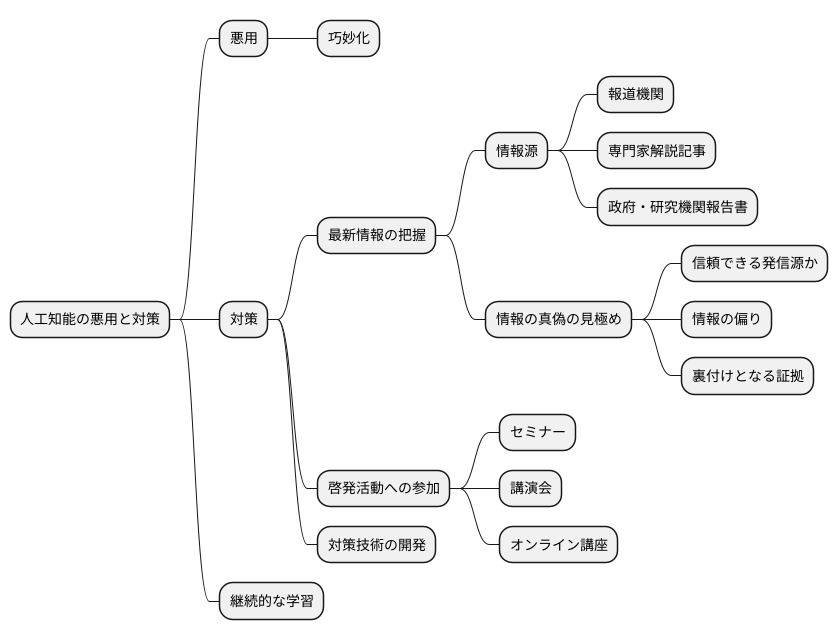

近頃、人工知能は目覚ましい発展を遂げており、私たちの暮らしを豊かにする可能性を秘めています。しかし、それと同時に、人工知能の悪用も巧妙化しており、常に最新の情報を把握し、適切な対策を講じることが重要となっています。

人工知能の悪用とその対策は、まるでいたちごっこのようです。悪用する者は常に新しい方法を考え出し、それに対抗するために新たな対策技術が開発されます。そして、その対策技術をすり抜ける、さらに高度な悪用技術が登場するのです。この循環は今後も続くことが予想され、私たちも常に学び続けなければなりません。

人工知能に関する最新の情報を手に入れるためには、様々な方法があります。例えば、新聞やテレビなどの報道機関、専門家による解説記事、政府や研究機関が発表する報告書など、信頼できる情報源から情報を得ることが大切です。また、情報の真偽を見極める能力も必要です。発信源が信頼できるか、情報が偏っていないか、裏付けとなる証拠はあるかなど、様々な観点から情報を吟味する習慣を身につけましょう。

さらに、政府や研究機関、企業などが行う情報セキュリティに関する啓発活動に積極的に参加することも有効です。セミナーや講演会、オンライン講座など、様々な機会が提供されています。これらの活動を通して、最新の知識や技術を学ぶことができるだけでなく、他の参加者と情報交換をする場としても活用できます。

人工知能は急速に進化しており、私たちを取り巻く環境も日々変化しています。最新の情報を常に把握し、適切な対策を講じることで、人工知能の悪用から身を守り、安全かつ効果的に人工知能技術を活用していくことができるでしょう。

今後の展望

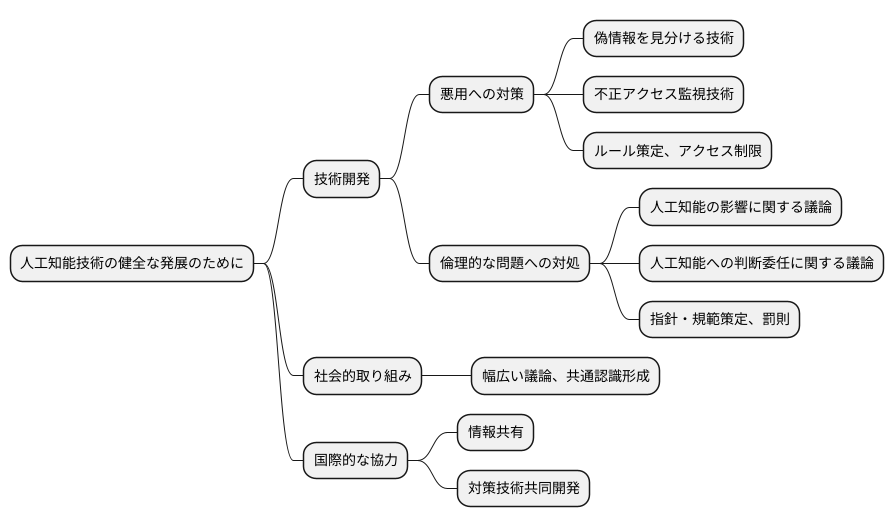

人工知能技術は、今後ますます発展し、私たちの暮らしの様々な場面で活用されていくと予想されます。より便利で豊かな社会の実現に貢献する一方で、使い方によっては、社会に混乱を招いたり、人々に危害を加えたりする可能性も秘めています。そのため、人工知能技術の健全な発展のためには、技術開発と同時に、悪用への対策や倫理的な問題についても真剣に考える必要があります。

人工知能技術が悪用される危険性は、技術の進化とともに高まっていきます。悪意のある人物が人工知能を利用して偽の情報を作ったり、他人を騙したり、犯罪行為を助長するといったことが起こりえます。そのため、悪用を早期に発見し、被害を最小限に抑えるための技術開発が急務です。具体的には、偽の情報を見分ける技術や、不正なアクセスを監視する技術などを開発し、常に改良していく必要があります。また、悪用される前に防ぐための対策も重要です。人工知能技術の利用に関するルールを定めたり、アクセス制限を設けたりすることで、悪意ある利用を未然に防ぐことができます。

さらに、人工知能技術の倫理的な側面についても、広く議論を深める必要があります。人工知能が人々の仕事や生活にどのような影響を与えるのか、どのような判断を人工知能に委ねて良いのか、といった問題について、様々な立場の人々が意見を交換し、社会全体の共通認識を形成していくことが重要です。人工知能技術を安全に利用するための指針や規範を定め、違反者には罰則を科すことも必要です。

国際的な協力も欠かせません。国境を越えて悪用される危険性があるため、各国が協力して対策を講じる必要があります。悪用に関する情報を共有したり、対策技術を共同で開発したりすることで、より効果的に悪用を防ぐことができます。人工知能技術の健全な発展のためには、技術開発だけでなく、社会的な取り組み、そして国際的な連携が不可欠です。私たちは、皆で協力して、人工知能技術の恩恵を安全に享受できる社会を目指していく必要があります。